Son dönemde açık kaynaklı büyük dil modellerinin (LLM’ler) yeni dalgası, özellikle Mixture of Experts (MoE) mimarilerini benimsemeye başladı. Geleneksel yoğun modellere kıyasla, MoE’ler, yalnızca belirli bir grup uzmanı – yani uzmanları – aktif hale getirerek çıkış sağlıyor. Bu seçici aktivasyon, hesaplama yükünü azaltıyor ve böylece daha hızlı sonuç süreleri ile düşük dağıtım maliyetleri sunuyor.

NVIDIA Dynamo’nun geliştirilmiş çıkış optimizasyon teknikleri ile birleştiğinde (örneğin, dağıtılmış sunum) ve NVIDIA GB200 NVL72 çipinin büyük ölçek mimarisi ile birleştiğinde, MoE modelleri, yeni seviyelerde çıkış verimliliği sunma potansiyeline sahip. Bu sinerji, yapay zeka fabrikalarının, kullanıcı isteklerini karşılamak için daha fazla talep sunmasına olanak tanıyor.

Bu blogda, mevcut araştırmamızdan elde edilen bulguları kullanıyoruz. Araştırmada, yüksek değerli bir veri merkezi ölçek GPU performans simülatörü kullanarak farklı donanım konfigürasyonları üzerinde yüz binlerce tasarım noktası değerlendirildi ve dağıtım ile geniş model paralelliğinin MoE çıkışına etkisi incelendi.

MoE Model Performansının Dağıtılmış Sunum ile Artırılması

2018 yılında Google Araştırmacıları tarafından tanıtılan BERT modelinden bu yana, model ağırlıkları 1,000 katın üzerinde arttı ve üretken çıkarım için hız ve etkileşim beklentileri yükseldi. Bu nedenle, modelleri birden fazla GPU üzerinde parçalamak için, model paralelliği teknikleri kullanmak, artık yaygın bir uygulama haline geldi. Bunlar arasında Tensor Paralelliği (TP), Pipeline Paralelliği (PP) ve Veri Paralelliği (DP) yer alıyor.

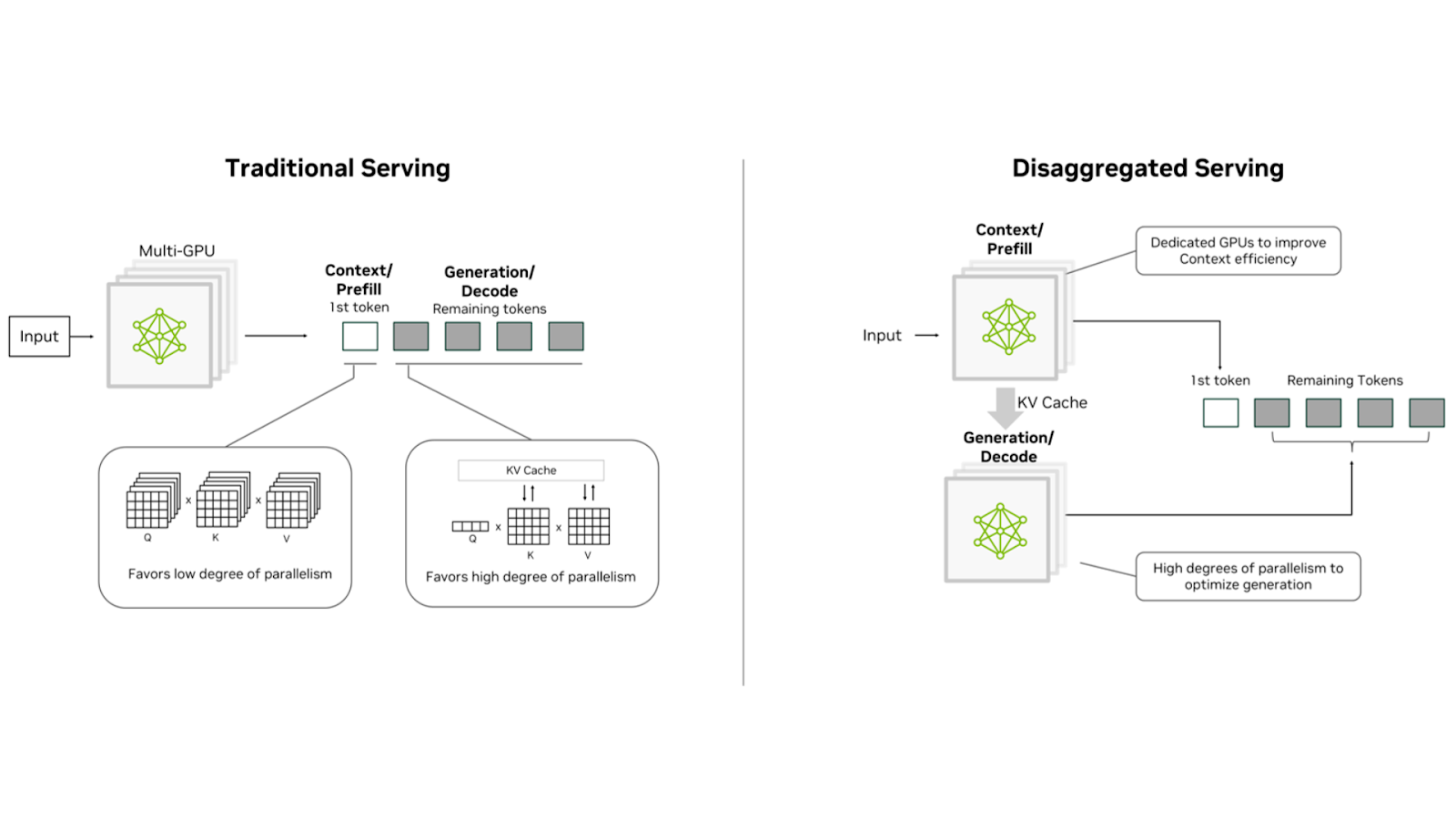

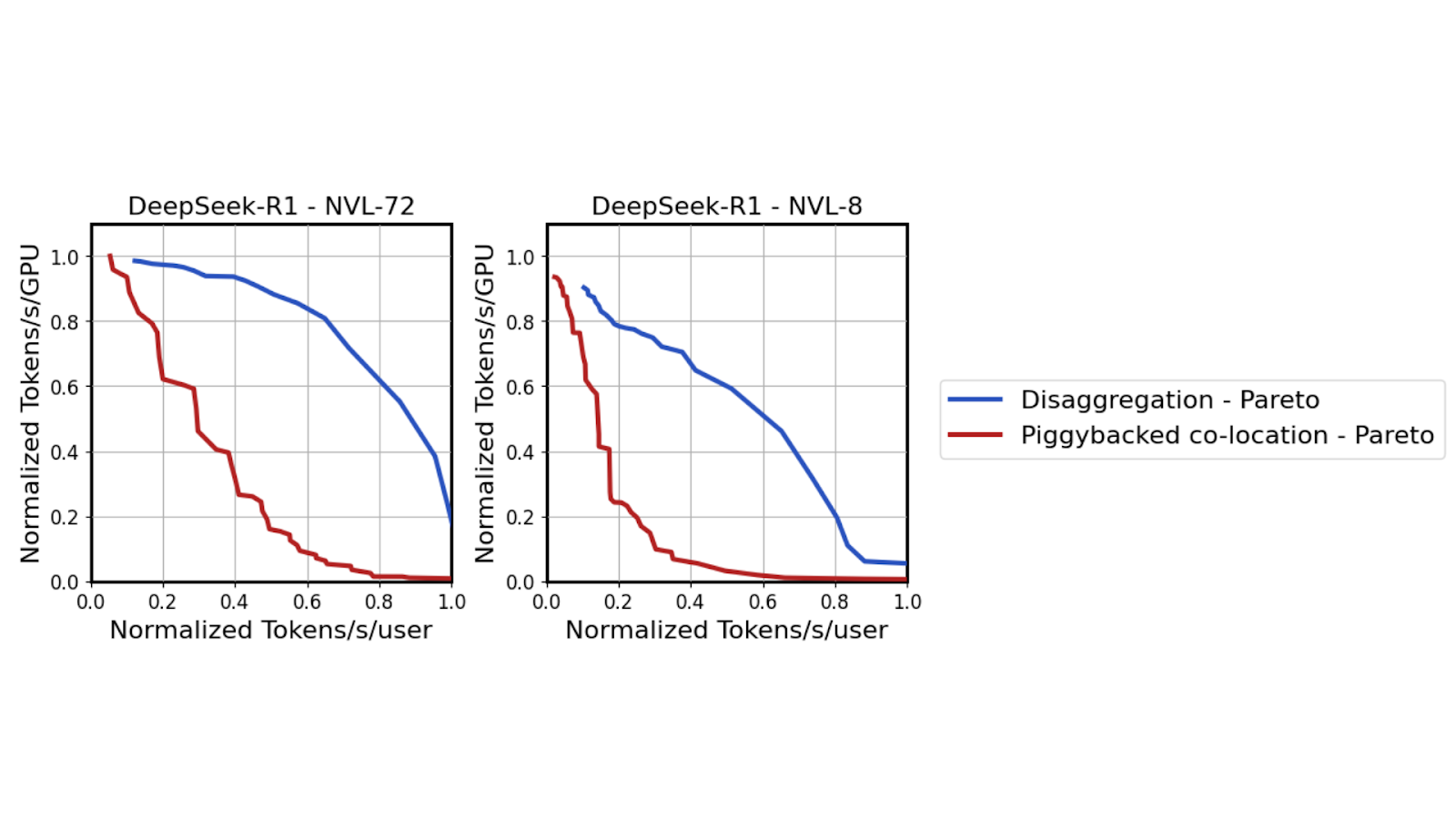

Geleneksel LLM dağıtımları genellikle, çıkarımın önceden doldurma ve çözümleme aşamalarını tek bir GPU veya düğümde birleştirir. Ancak, doğal olarak token-paralel olan önceden doldurma aşaması, otoregresif çözümleme aşamasından farklı kaynak gereksinimlerine sahiptir. Tipik hizmet senaryolarında, bu aşamalara uygulanabilir hizmet seviyeleri (SLA’lar) de farklıdır; önceden doldurma için İlk Token Zamanı (TTFT) gereksinimleri ve çözümleme için Token’lar Arası Gecikme (ITL) gereksinimleri vardır. Bu nedenle, her aşama different model paralellik seçimlerinden faydalanır. Bu aşamaların birleştirilmesi, özellikle uzun giriş dizileri için verimsiz kaynak kullanımına yol açar.

Dağıtılmış sunum, bu aşamaları farklı GPU’lar veya GPU düğümleri arasında ayırarak bağımsız optimizasyon sağlar. Bu ayrım, çeşitli model paralellliği stratejilerinin uygulanmasına ve her aşamanın özel ihtiyaçlarını karşılamak için farklı sayıda GPU cihazı atanmasına olanak tanır.

MoE modelleri, modeli uzmanlara böler. Her zaman tam modeli her token için aktifleştirmek yerine, bir kapı mekanizması dinamik olarak bu uzmanların küçük bir alt kümesini işlem için seçer. Her gelen token, seçilen uzmanlara yönlendirilir; bu uzmanlar, hesaplamaları gerçekleştirir ve sonuçları tüm-güçlü GPU iletişimi aracılığıyla değiş tokuş eder.

MoE’lerin benzersiz mimarisi, Uzman Paralelliği (EP) adı verilen yeni bir model paralellik boyutunun tanıtılmasına olanak tanır. EP ile model uzmanları GPU’lar arasında dağıtılır, bu da daha zengin model paralel eşleştirmeler sağlar ve kaynak kullanımını artırır. EP’nin, DP, TP ve PP gibi mevcut model paralellik tekniklerinin yanı sıra dağıtılmış sunumda MoE modellerini sunma açısından olağanüstü bir model arama alanı genişlemesi sağlar.

NVIDIA Dynamo, MoE Modelleri için Dağıtılmış Sunumu Güçlendiriyor

NVIDIA Dynamo, veri merkezi ölçeğinde modelleri dağıtmak için tasarlanmış dağıtılmış bir çıkarım sunum çerçevesidir. Dağıtılmış sunum mimarilerinin getirdiği karmaşıklıkları basitleştirir ve otomatikleştirir. Bu, önceden doldurma ve çözümleme GPU’ları arasındaki KV cache’in hızlı aktarımını yönetmeyi, gelen istekleri etkili bir şekilde yönlendirmeyi içerir.

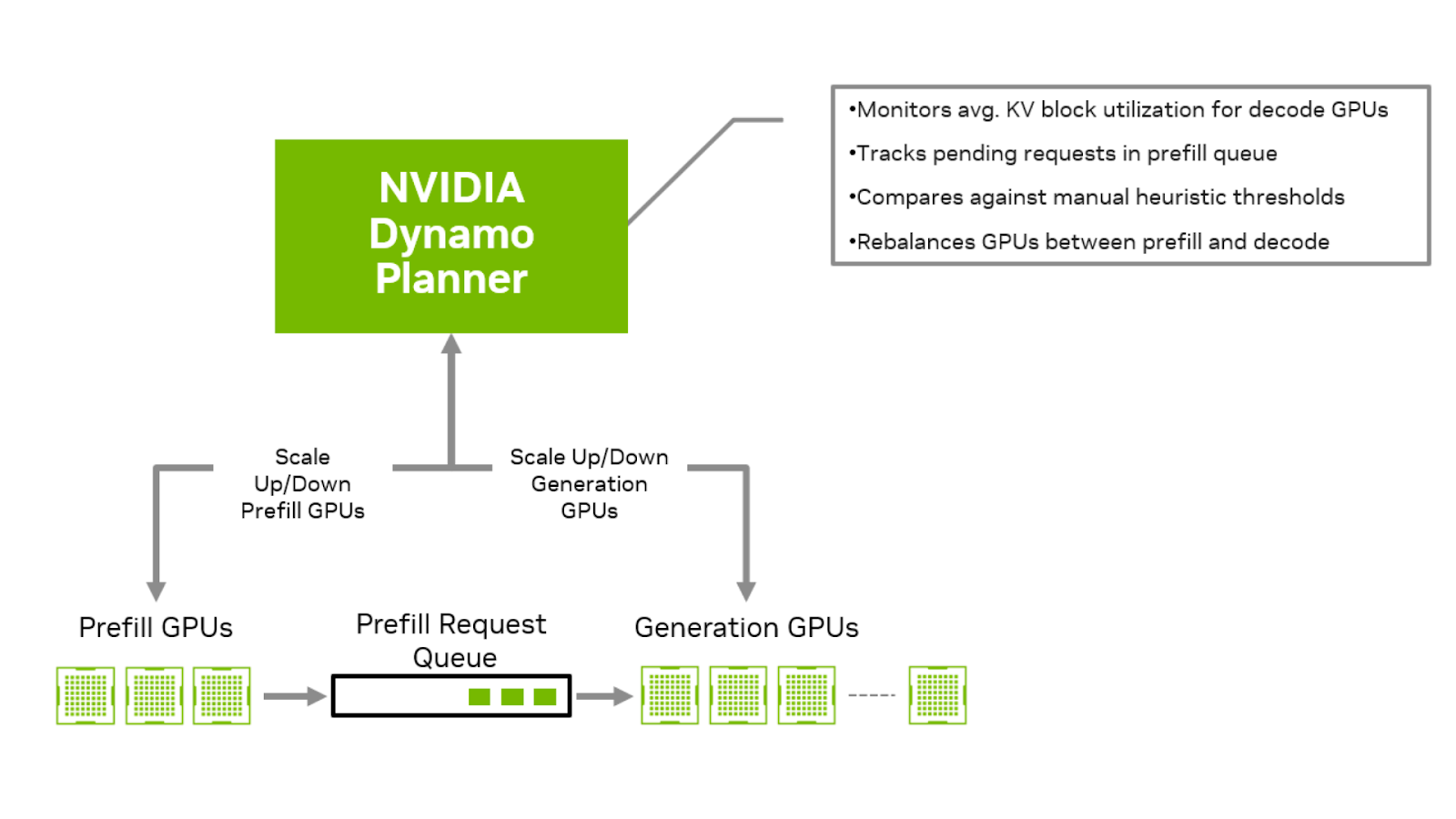

Dağıtılmış bir kurulumda en önemli zorluklardan biri, önceden doldurma ve çözümleme GPU’ları arasında istek oranlarının eşleştirilmesidir. Dinamik oran eşleştirmesi, kaynakların önceden doldurma ve çözümleme aşamaları arasındaki yük bazında tahsis edilmesini sağlar. Bu, önceden doldurma ile çözümleme arasında KV cache beklerken çözümleme GPU’larının boş beklemesini engeller ve önceden doldurma görevlerinin, çözümleme aşamasında sıraya girmesini önler.

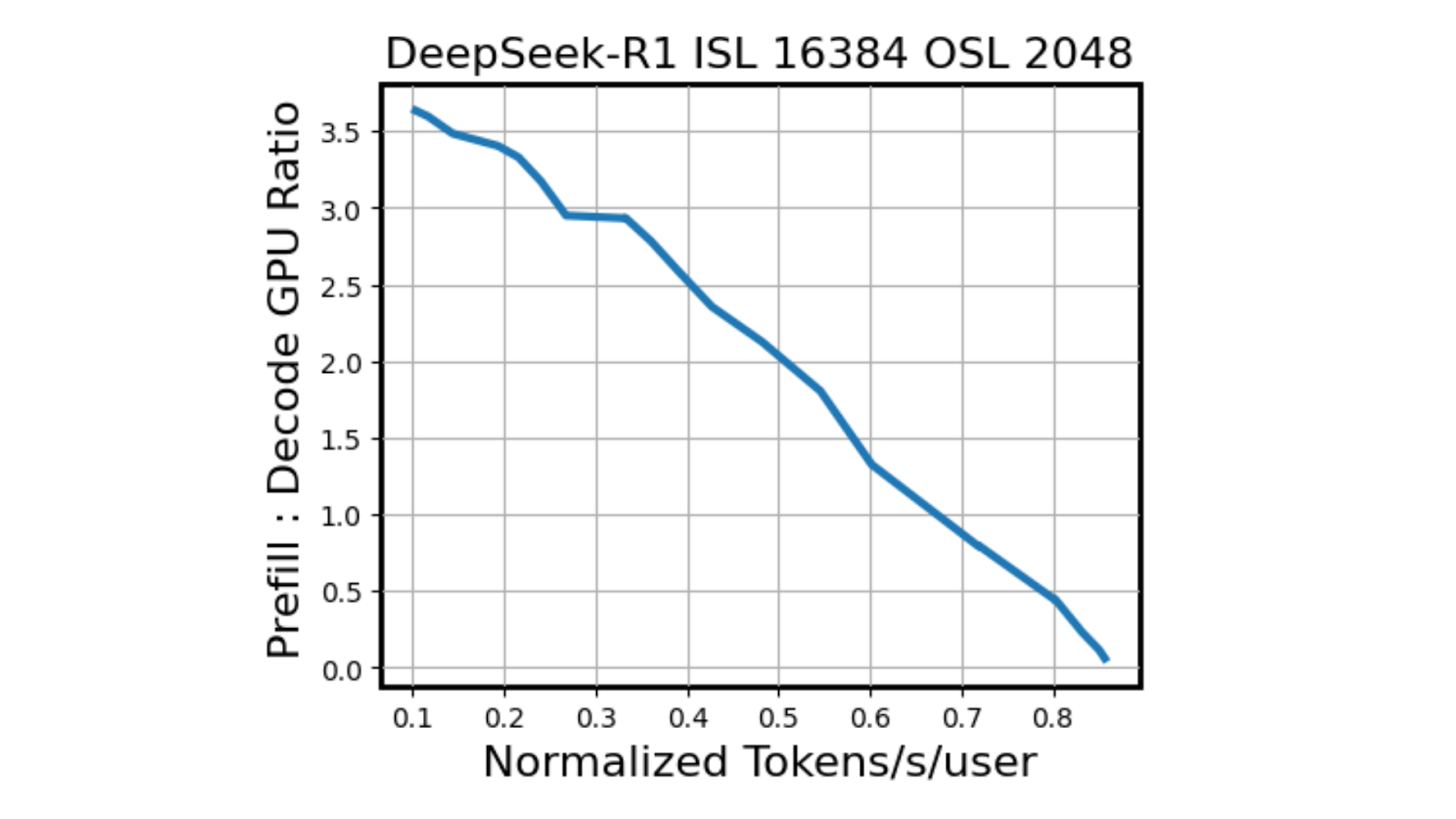

Şekil 2’ye baktığımızda, her mavi nokta yalnızca önceden doldurma ve çözümleme model paralel konfigürasyonlarının benzersiz bir kombinasyonunu değil, aynı zamanda önceden doldurma ve çözümleme GPU’ları arasında dikkatlice dengelenmiş bir oran eşleştirmesini temsil eder. Bu oran eşleştirmesi, sabit Giriş Dizisi Uzunluğu (ISL) ve Çıkış Dizisi Uzunluğu (OSL) kombinasyonları için hesaplanabilirken, gerçek dünya dağıtımları daha büyük bir zorluk sunar. ISL ve OSL’ler genellikle bir isteğe bağlı olarak değişir, bu da tutarlı oran eşleştirmeyi oldukça karmaşık hale getirir.

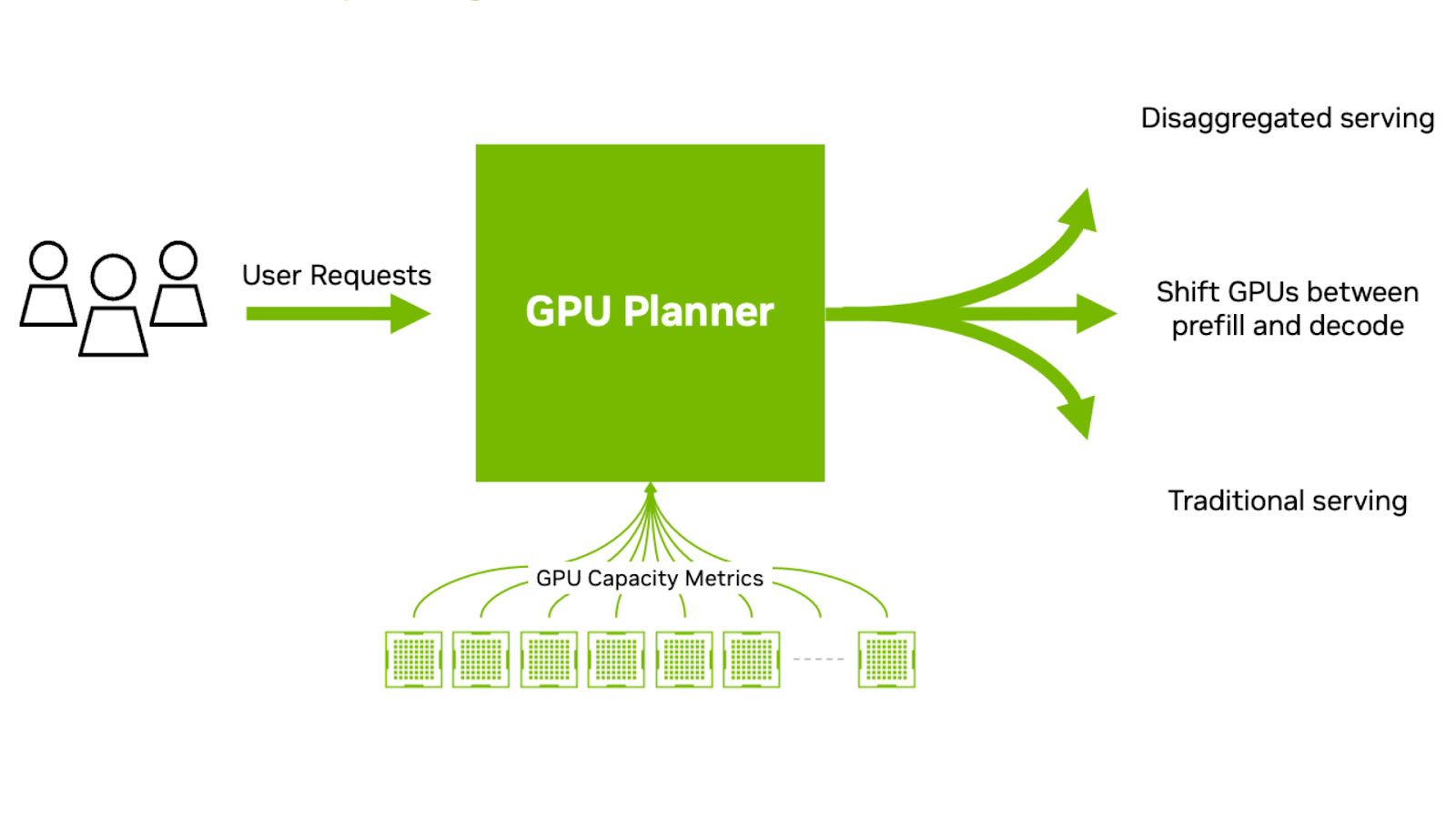

Bunu ele almak için NVIDIA Dynamo, dalgalanan yükler için önceden doldurma ve çözümleme GPU’ları arasında oran eşleştirmeyi otomatikleştirmek için tasarlanmış özel bir motor, Planlayıcı içerir. Bu, önceden doldurma kuyruk zamanı, çözümleme için KV Cache bellek kullanımı ve uygulama SLA’larını değerlendirerek GPU kaynaklarının optimal konfigürasyonunu belirler. Bu, gelen isteklerin türlerini, hangi yönde ve hangi oranlarda ölçeklendireceğini, değişen giriş ve çıkış dizisi taleplerine göre akıllıca karar verir.

Dağıtılmış sunum, uzun ISL/OSL trafik modellerinin geniş bir yelpazesinden faydalanır; özellikle önceden doldurma ağırlıklı iş yükleri, dengelemeye çalışan toplu dağıtımda önemli ölçüde zarar görebilir.

Uzun ve kısa ISL ve OSL arasında iş yükleri değiştiğinde, Dynamo Planlayıcısı, bu değişikliklere yanıt verebilir ve gelen istekleri, çözümleme GPU’ları üzerinde geleneksel birleşik dağıtımlar veya hem önceden doldurma hem de çözümleme GPU’ları arasında dağıtılmış sunum ile sunma seçeneğini belirleyebilir. Bu, dalgalanan iş yüklerine uyum sağlar ve GPU kullanımını optimize eder.

NVIDIA GB200 NVL72 NVLink Mimarisi Kullanma

MoE modellerinde, her giriş tokeni, dinamik olarak seçilen uzmanların küçük bir alt kümesine yönlendirilir. DeepSeek R1 modelinde, her token, 256 uzman havuzunun yalnızca sekiz uzmanına yönlendirilir. Bu seçilmiş uzmanlar, bağımsız olarak çıkış hesaplamalarının bir kısmını gerçekleştirir ve ardından her biri, sonuçlarını ve paylaşılan uzman ile beraber diğerleriyle bir tüm-güçlü iletişim modeli aracılığıyla değiş tokuş eder.

MoE modellerinin performans avantajlarını gerçekten kullanabilmek için, çözümleme aşamasının geniş bir EP kurulumuyla tasarlanması önemlidir. Bu, uzmanların GPU’lar arasında dağıtılması anlamına gelir ve her GPU, az sayıda uzmandan sorumlu olur. DeepSeek R1 modeli için bu genellikle, çözümleme sırasında 256 yönlendirilmiş uzmandan dört uzmanın her GPU’ya düşmesiyle 64 GPU gerektirir.

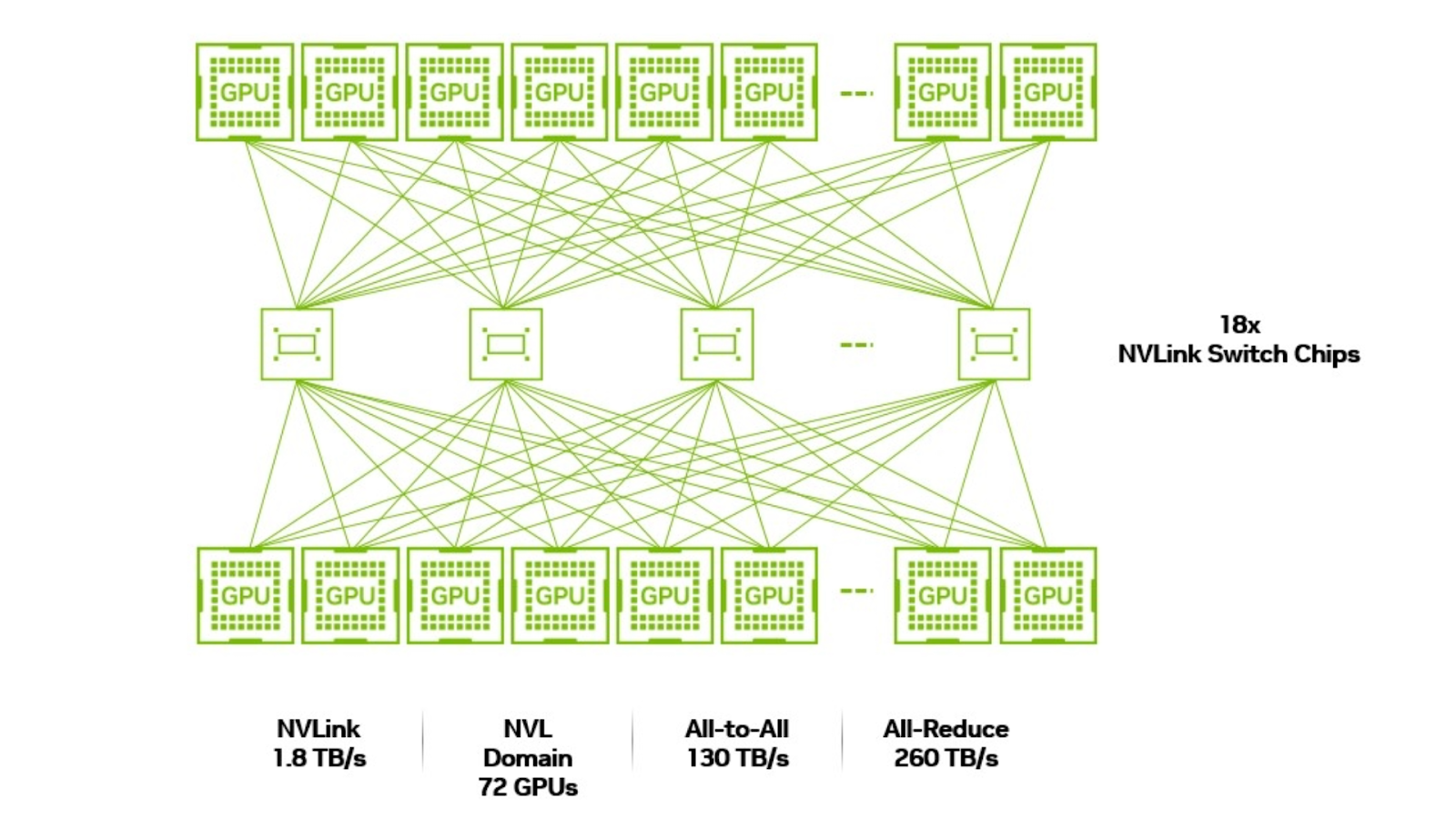

Ancak, seçilen uzmanlar arasında gerçekleştirilen tüm-güçlü iletişim, önemli ağ zorluklarını da beraberinde getiriyor. Her çözümleme ile ilgili uzman, aynı token için seçilen diğer yedi uzman ile veri değiş tokuşu yapmak zorundadır; bu sebeple, tüm 256 uzman ile birlikte, bu uzmanların ev sahipliği yaptığı 64 GPU’nun aynı düşük gecikmeli, yüksek bant genişliğine sahip bir alan içinde çalışması kritik hale geliyor. Eğer seçilen uzmanlar farklı düğümlerdeki GPU’larda bulunuyorsa, tüm-güçlü iletişim, daha yavaş iletişim protokollerine, örneğin InfiniBand’a, takılma riski taşır.

Bu seviyede iletişim verimliliğini sağlamak için, 64 GPU’nun hepsinin birbirine sıkı bir şekilde bağlanmış bir yapılandırmaya sahip olması gerekir; bu sayede, iletişim darboğazlarını önlemek ve verimliliği artırmak mümkün olur.

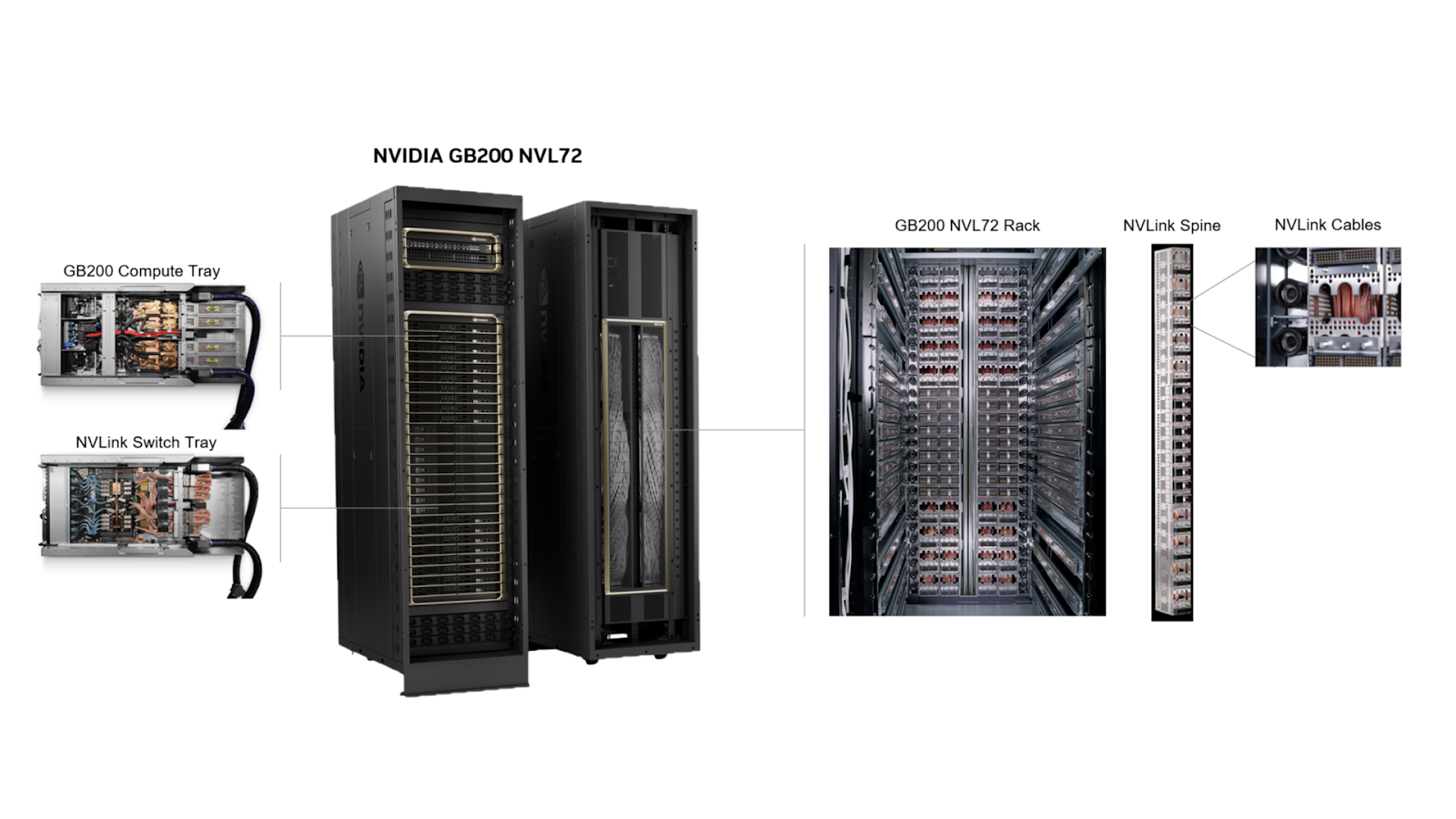

NVIDIA GB200 NVL72’nin tanıtılmasından önce, tek bir NVLink alanına bağlanabilecek GPU’ların maksimum sayısı sekiz ile sınırlıydı. GB200 NVL72 tasarımının getirdiği devrim, artık NVLink alanının 72 NVIDIA Blackwell GPU’sunu destekleyebilmesi ve her GPU’nun iletişim hızının 1.8 TB/sn olmasıdır. Bu, 400 Gbps Ethernet standartlarından 36 kat daha hızlıdır. Bu büyüme, GB200 NVL72’yi, dağıtılmış yapılar için geniş EP ile MoE modellerinin sunulmasında ideal bir seçim haline getirmektedir.

Yalnızca MoE’ler Değil: NVIDIA GB200 NVL72 ve NVIDIA Dynamo Yoğun Modelleri Hızlandırıyor

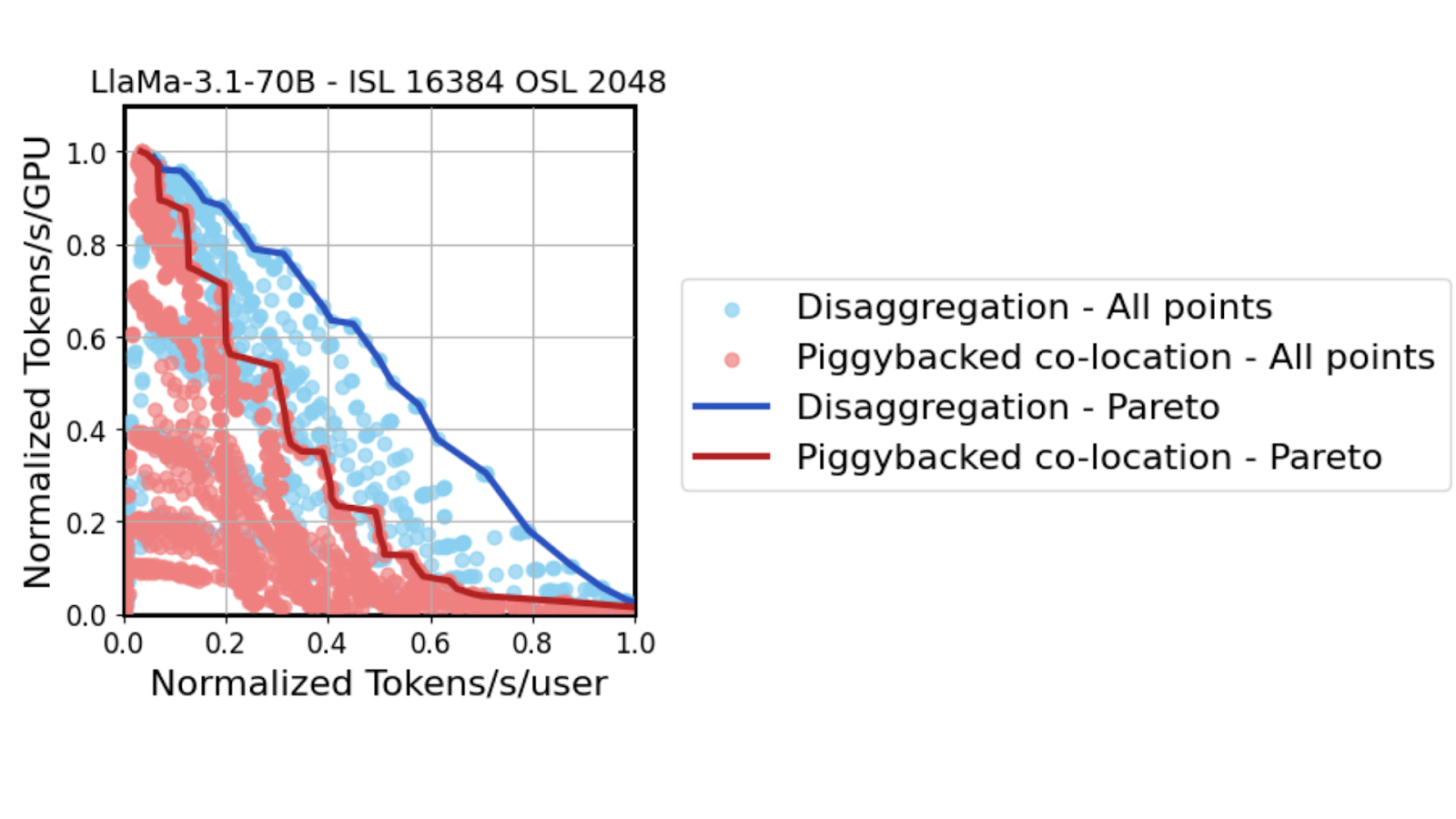

GB200 NVL72 ve Dynamo, yalnızca MoE modellerini hızlandırmakla kalmaz, aynı zamanda popüler açık kaynak Llama 70B modeli gibi geleneksel yoğun modellere de önemli performans artışları sağlar.

Aynı yüksek değerli GPU performans simülatörü kullanılarak Llama 70B modeli hizmete sunulurken, TTL kısıtlamaları sıkılaştıkça (x ekseninde sola kayarken), tensor paralelliğinin 2 GPU’dan 64 GPU’ya kadar ölçeklenmesi gerektiği gösterilmiştir. Her iki yerleştirme de, sıkı TTL SLA’lar altında yüksek tensor paralelliğini tercih etse de, dağıtılmış çözümleme bu stratejiyi daha agresif bir şekilde benimseyebilir.

Önceden doldurmanın matematik açısından yoğun performansını dengelemek zorunda kalmadan, Dynamo dağıtılmış çözümleme kurulumları, sıkı gecikme taleplerine daha iyi uyum sağlayabilir. Ayrıca, GB200 NVL72’nin ölçeklenebilir mimarisi, TP çözümleme dağıtımında tüm GPU’ların iletişim kurmasını sağlayarak 260 TB/sn hıza kadar artış sağlıyor. Bu, aynı ortalama gecikme süresinde %300’e kadar performans artışı sağlıyor.

Sonuç

NVIDIA Dynamo ve NVIDIA GB200 NVL72’nin birleşimi, yapay zeka fabrikalarının üretimde olan MoE modelleri, DeepSeek R1 gibi, ve yeni piyasaya sürülen Llama 4 gibi, çıkarım performanslarını optimize eden güçlü bir sinerji yaratıyor. NVIDIA Dynamo, MoE modellerinin dağıtımı için karmaşık zorlukları otomatikleştirirken, önceden doldurma ve çözümleme otomatik ölçeklendirmesi ile oran eşleştirme gibi görevleri yönetiyor.

NVIDIA GB200 NVL72, dağıtılmış MoE dağıtımları için geniş uzman-paralel çözümleme gereksinimlerini hızlandırabilecek eşsiz bir ölçekleme mimarisi sunuyor. Birlikte, yapay zeka fabrikalarının GPU kullanımını maksimize etmelerini, her yatırım başına daha fazla talep sunmalarını ve sürekli marj büyümesini sağlamalarını mümkün kılıyor.

DeepSeek R1 ve Llama modellerinin geniş ölçekli GPU kümelerinde dağıtımı hakkında daha fazla teknik detay için, buradan teknik beyaz kağıdımıza göz atabilirsiniz.