NVIDIA’nın Kurumsal Referans Mimarileri (Enterprise RAs), yapay zeka altyapı çözümlerinin kurulum süresini ve maliyetini azaltma potansiyeline sahip. Bu mimariler, uyumluluk ve birlikte çalışabilirliği garanti ederken, esnek ve maliyet etkili bir hızlandırılmış altyapı oluşturmanın akıllı bir yolunu sunar.

En son Kurumsal RA, yapay zeka için NVIDIA GH200 NVL2 ile entegre sistemler için optimize edilmiş bir küme konfigürasyonunu detaylandırıyor. NVIDIA GH200 NVL2’nin performans artırıcı “sır”, iki GH200 süperçipin NVLink ile bağlanarak benzersiz bir bellek alanı oluşturmasıdır. Bu da hızlandırılmış uygulamaları geliştirirken bellek yönetimini basitleştirir.

NVIDIA GH200 Süperçipi, enerji verimliliği yüksek NVIDIA Grace CPU ile güçlü NVIDIA Hopper GPU‘yu, yüksek bant genişliğine ve bellek bütünlüğüne sahip NVIDIA NVLink-C2C ile birleştirir. NVIDIA GH200 NVL2, tek bir düğümde iki NVIDIA GH200 Süperçipini bir araya getirir. Tek düğüm LLM çıkarımı, görev artırılmış çıkarım (RAG), önericiler, grafik sinir ağları (GNN), yüksek performanslı hesaplama (HPC) ve veri işleme gibi hesaplama ve bellek yoğun görevler, NVIDIA GH200 NVL2 üzerinde etkileyici bir performans sergiler.

GH200 NVL2 ile Bellek Yönetimini Basitleştirmek

GH200 NVL2, geliştiricilerin sistem belleğine erişimini ve kullanımını kolaylaştırmak üzere tasarlanmıştır. NVIDIA Grace Hopper mimarisi, NVIDIA Hopper GPU’nun çığır açan performansını, NVIDIA Grace CPU’sunun esnekliği ile birleştirir. Bu kombinasyon, 900 GB/sn’ye kadar bant genişliği sunan yüksek bant genişliğine sahip, bellek bütünlüğüne sahip NVLink chip-to-chip (C2C) bağlantısıyla sağlanır. Bu, PCIe Gen 5’in 7 katı bir bant genişliği sunarak, geliştiricilerin bellek yönetimine daha az odaklanmasını sağlar.

Birleşik Bellek Modeli

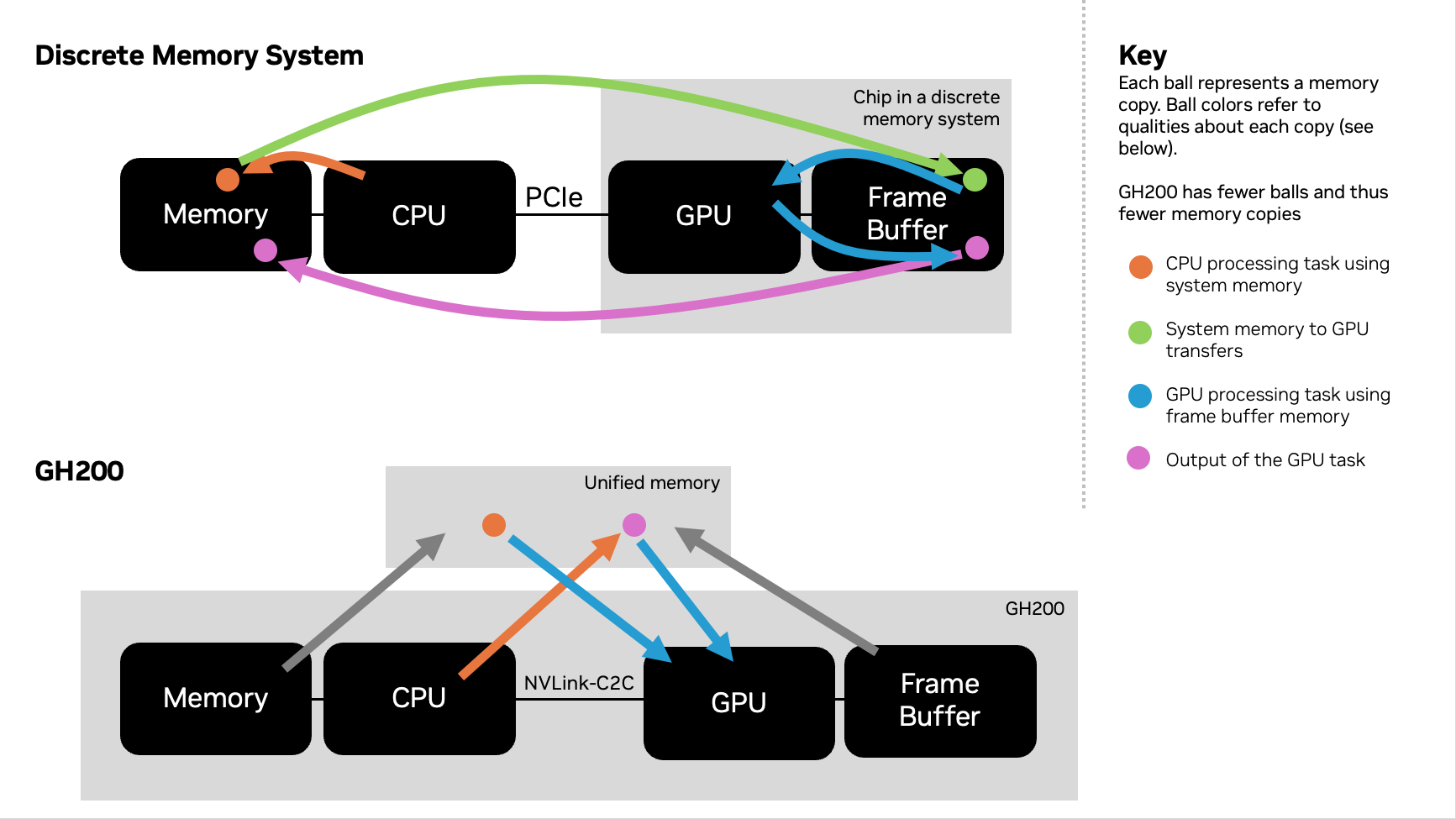

GH200 mimarisi, NVIDIA Grace CPU ile Hopper GPU’yu NVLink chip-to-chip (NVLink-C2C) aracılığıyla entegre ederek birleştirilmiş bir bellek modeli oluşturur. Bu unified virtual memory model (UVM), CPU ve GPU iş parçacıklarının hem CPU’ya hem de GPU’ya ait belleğe kesintisiz erişim sağlamasına olanak tanır ve tüm işlemleri tek bir adres alanında gerçekleştirilir. Bu sistem, bellek aşırı kullanımı, talep üzerine sayfalama ve veri tutarlılığı gibi birçok senaryoyu kolaylaştırır.

Yüksek Bant Genişliğine Erişim

NVIDIA GH200 NVL2’deki NVLink-C2C bağlantısı, geleneksel sunucu mimarisine kıyasla 7 kat hız artışıyla 900 GB/s bant genişliği sunar. Bu yüksek bant genişliği, GPU’nun doğrudan CPU belleğini kullanabilmesini sağlamakta, bellek kopyalama işlemleriyle ilişkili yükümlülükleri de azaltmaktadır.

Tablo 1, en son Kurumsal RA’dan alınan ve GH200 ile GH200 NVL2’nin bellek özelliklerini karşılaştıran bir sistemi göstermektedir.

| Spesifikasyon | NVIDIA GH200 Grace Hopper Süperçipi | NVIDIA GH200 NVL2 Sistemi |

| HBM3e belleği per GPU | 144 GB HBM3e | 288 GB HBM3e |

| Çözüm başına hızlı bellek | 624 GB’a kadar | 1248 GB’a kadar |

| GPU bellek bant genişliği | 4.9 TB/sn’ye kadar | 9.8 TB/sn’ye kadar |

| Bağlantı | CPU-GPU NVLink-C2C: 900 GB/sn CPU-CPU NVLink-C2C: Yok GPU-GPU NVLink: Yok PCIe Gen5 x16: 128 GB/sn |

CPU-GPU NVLink-C2C: 900 GB/sn CPU-CPU NVLink-C2C: 600 GB/sn GPU-GPU NVLink: 900 GB/sn PCIe Gen5 x16: 128 GB/sn |

Belirli Bellek Koheransı

Adres Çeviri Hizmetleri (ATS) mekanizması, GH200 NVL2’nin tutarlı bir bellek modelini desteklemesini sağlar. Koheranslı bellek, CPU ve GPU’dan paylaşılan bellekte görünmeyen okuma-değiştirme-yazma işlemlerine olanak tanır. ATS, bellek yönetimi ve kopyalama ihtiyaçlarını azaltır.

GPU Bellek Aşırı Kullanımı

Bu süperçipin mimarisi, GPU’nun, yüksek bant genişliği ile NVIDIA Grace CPU belleğini kullanarak sınırlarını aşabilmesini kasıtlı olarak sağlar. Her bir Grace Hopper Süperçipi, 480 GB LPDDR5X ve 144 GB HBM3e ile birlikte toplamda 1248 GB sunmaktadır. Bu da daha fazla belleğin erişilebilir olmasını sağlar.

Hızlandırılmış Toplu Aktarımlar

NVIDIA Hopper Direkt Bellek Erişimi (DMA) kopyalama motorları, GH200’ün bellek kopyalamasındaki güçlerini artırır. NVLink-C2C destekli olan bu düzenek, ana bilgisayar ve cihaz arasında sayfalık belleğin (sisteme girip çıkan bellek) hızlandırılmış aktarımlarını sağlar.

Tüm bu teknolojiler, GH200’ün verimliliklerini arttırarak, bellek kopyalama gereksinimlerini azaltır. Şekil 1, ayrık bir bellek sisteminin (kopyalar yapıldığı) GH200 ile karşılaştırıldığında bellek kopyalamanın farkını görsel olarak ortaya koymaktadır.

GH200 NVL2’de PyTorch Desteği

GH200 birleşik bellek için optimize edilmiş bir yazılım güncellemesi, sistemi bir üst seviyeye taşıyor.

AI geliştirenler, GH200 NVL2 üzerine yeni eklenen Universal Virtual Memory (UVM) desteğini takdir edecektir. AI çerçevesi GH200 NVL2 üzerinde mükemmel bir performans sergiliyor; çünkü Grace Hopper mimarisi, tüm bellek havuzuna erişimi mümkün kılıyor. Geliştiricilerin GPU belleğine sığdırmakla ilgili endişeleri artık olmayacak. GH200 NVL2, GPU belleğini aşırı kullanmaya izin verecek şekilde tasarlanmış.

Önceki geliştirme yöntemleri, geliştiricileri GPU belleklerini kullanmakta korumaya zorluyordu. Ancak artık, GH200 NVL2 ile geliştiriciler tüm belleği kullanabilir.

GH200 NVL2 için Tavsiye Edilen Konfigürasyon

NVIDIA, GH200 NVL2 ve NVIDIA Spectrum-X için yeni bir Kurumsal RA ve adlandırma güncellemesi sunmaktadır. 2-2-3-400 şeklindeki sunucu konfigürasyonu, sunucu üzerindeki CPU, GPU ve ağ adaptörlerinin sayısını ifade eder. Dördüncü sayı, 400, her bir GPU başına doğu-batı ağ bant genişliğini gigabit/saniye cinsinden belirtir.

GH200 NVL2 ile İnşaya Başlayın

Basitleştirilmiş bellek yönetimi sayesinde, GH200 NVL2 gerçek dünyadaki uygulamalarda performansı artırıyor. Çoklu dönüşlü çıkarım, büyük veri analitiği ve ölçeklenebilir veri işleme, GH200 birleşik CPU+GPU mimarisinden direkt faydalanıyor.

GH200 NVL2 için 2-2-3-400 sunucu konfigürasyonu, NVIDIA’nın global ortakları tarafından da destekleniyor. Örneğin, HPE ProLiant Compute DL384 Gen12 ve Supermicro ARS-221GL-NHIR gibi seçenekler mevcuttur.

NVIDIA, GH200 NVL2 için Kurumsal RA’yı sağlayarak, birleşik bellek verimliliğinden yararlanarak ölçeklenebilir veri merkezi çözümleri oluşturmak için kanıtlanmış ve kapsamlı tasarım önerileri sunmaktadır.

Kurumsal Referans Mimarileri ve NVIDIA GH200 performansı hakkında daha fazla bilgi için en son MLPerf Çıkarım sonuçlarına göz atın.

NVIDIA GTC 2025’te Kurumsal Referans Mimari ekibiyle bizzat görüşerek, NVIDIA GTC 2025‘teki oturumları planınıza ekleyin. Bu oturumda, bir NVIDIA mimarından cluster tasarım sorularınıza cevap alabilirsiniz: NVIDIA Kurumsal Referans Mimarileri Hakkında Her Şey [CWE74549].

NVIDIA Grace Hopper ekibi, aşağıdaki oturumları da düzenleyecek:

- Grace Hopper’dan Maksimum Performans Alın [S72687]

- Üretken AI Çağı için Veri Platformlarının Geleceğini Şekillendirmek [S71650]

- GPU’larınızı Sürekli Çalıştırın: Model Eğitimindeki Boşluğu Kapatın [S73733]

- GPU Sistemlerinde Veri Analitiği İş Akışlarını Hızlandırma [CWE72882]

- Birleşik Bellek ile Grace Hopper’da Fortran Standart Paralelliği [P72780]

- C++ ile GPU ve CPU’da Sayısal Hesaplamayı Turboşarj Etme [CWE72491]

- NVIDIA’nın Grace Hopper, Grace Blackwell ve Grace CPU Süperçipleri ile Arm Neoverse Çekirdeklerinde AI Potansiyelini Maksimize Edin [S74288] (Arm tarafından sunulmuştur)

- NVIDIA Grace CPU için Uygulama Optimizasyonu [S72978]

- Geliştirici Araç Kıtalarınızda Neler Var? CUDA ve Grafik Profil Oluşturma, Optimizasyon ve Hata Ayıklama Araçları [CWE72393]