Büyük dil modelleri (LLM’ler) ve geri alma destekli üretim (RAG) sistemlerinin değerlendirilmesi karmaşık bir süreçtir ve bu sistemlerin çok boyutlu karakterini yansıtır. Geleneksel makine öğrenimi (ML) modellerinin aksine, LLM’ler çok çeşitli ve genellikle tahmin edilemeyen çıktılar üretir; bu da standart değerlendirme metriklerini yetersiz kılar.

Bu değerlendirmede karşılaşılan ana zorluklar arasında görevler için kesin bir gerçeklik eksikliği, veri kirlenmesi riski ve modellerin istem değişikliklerine ve kodlama stratejilerine karşı duyarlılığı yer alır. Üstelik, LLM’ler yüksek kaliteli çıktılar üreterek düşük kaliteli insan referanslarını aşabileceğinden, geleneksel referans esaslı metrikler yetersiz kalabilir.

Bu yazıda, LLM’ler ve RAG sistemlerinin doğruluğunu ve güvenilirliğini değerlendirmek için sağlam teknikler ve en iyi uygulamalar araştırılacaktır.

LLM Değerlendirmesinin Önemi

Üretken yapay zeka uygulamaları geliştirilirken, titiz bir değerlendirme süreci, sistemin etkinliğini ve güvenilirliğini sağlamak için kritik öneme sahiptir. Bu süreç, kullanıcı memnuniyetini doğrulamaktan, AI’nın beklentileri karşıladığını ve anlamlı etkileşimler sağladığını onaylamaya kadar birçok önemli işlevi yerine getirir. Ayrıca, çıktıların tutarlılığını sağlamakla, üretilen içeriğin mantıksal olarak tutarlı ve bağlama uygun olduğunu doğrular.

Mevcut kıyaslamalara karşı performansı değerlendirerek, ilerleme ve rekabet konumunu açık bir şekilde ölçer. Önemli olarak, değerlendirme riskleri tespit edip azaltma konusunda katkıda bulunur; bunu, önyargılar, toksisite veya diğer zararlı çıktıları belirleyerek etik yapay zeka uygulamalarını teşvik ederek gerçekleştirir. Gelecek geliştirmelere yön vermek için güçlü ve zayıf yönleri belirler. Son olarak, değerlendirme gerçek dünya uygulamalarının uygunluğunu ölçmek için modellerin pratik senaryolar için hazır olup olmadığını belirler.

LLM Değerlendirmesindeki Zorluklar

Üretken yapay zeka uygulamalarının sağlam bir değerlendirme sürecini tasarlamak, bir dizi karmaşık zorlukla başa çıkmayı gerektirir. Bu zorluklar geniş ölçüde iki ana kategoride toplanabilir: değerlendirme sonuçlarının güvenilirliğini sağlamak ve değerlendirme sürecini daha büyük AI iş akışlarına entegre etmek.

Güvenilir Değerlendirme Sonuçları Sağlama

Etkin bir değerlendirme, modelin performansı hakkında güvenilir bilgiler üretmelidir; bu ise aşağıdaki faktörler nedeniyle karmaşık hale gelir:

- Veri mevcudu

- Alan özel boşluklar: Özel alanlar için uygun kıstasların eksikliği değerlendirmelerin geçerliliğini ve derinliğini kısıtlamakta ve gerçek dünya uygulanabilirliğini değerlendirmekte zorluklar yaratmaktadır.

- İnsan anotasyon sınırlamaları: Yeterli kaynak sağlamak için anotatörler bulmak ve yüksek kaliteli, sentetik olmayan veri setleri oluşturmak zaman alıcı ve maliyetli olabilir.

- Veri kalitesi

- Önyargılı değerlendirmeler: LLM’lerin diğer LLM’leri değerlendirmek için kullanılması, sonuçları çarpıtacak önyargılar ekleyebilir ve değerlendirmelerin doğruluğunu tehlikeye atabilir.

- Tekniklerin eksikliği

- Mevcut tekniklere aşırı uyum: Mevcut değerlendirme yöntemlerine aşırı bağımlılık, modellerin bu teknikler için optimize edilmesi riskini taşır, bu da gerçek performans iyileştirmeleri elde edilmesini zorlaştırır.

- Ajans iş akışları

- Çok turlu etkileşim: Tek tur etkileşimlerin aksine, çok turlu konuşmaların değerlendirilmesi, karmaşık değerlendirme tasarımları gerektirir; bu da nüansları yakalamak ve uzun süreli etkileşimler boyunca tutarlılığı sağlamak için zorlayıcıdır.

- İş akışı tutarlılığı: Çok ajanslı etkileşimlerin genel tutarlılığı ve etkinliğinin değerlendirilmesi özel bir zorluktur. Ajanların birlikte nasıl çalıştığını, alt görevlerde tutarlılığı nasıl sağladıklarını ve bütünleşik çıktılar üretip üretmediklerini değerlendirmek çok önemlidir.

AI İş Akışlarına Değerlendirme Sürecini Entegre Etme

AI geliştirme iş akışlarına değerlendirme süreçlerini entegre etmek, ek zorluklar da yaratmaktadır:

- Sürekli değerlendirme: Üretimdeki modellerin, zaman içinde performans ve güvenilirliği sağlamak için sürekli olarak değerlendirilmesi gerekir; bu da değerlendirme araçlarının sorunsuz entegrasyonunu gerektirir.

- Gerçek zamanlı geri bildirim: Geliştirme sürecinde anlık geri bildirim mekanizmaları uygulamak zorlu olsa da, bu, sürekli iyileştirme için kritik öneme sahiptir.

- Çapraz platform uyumluluğu: Değerlendirme araçları, tutarlı ve ölçeklenebilir değerlendirmeler sağlamak için çeşitli platformlar ve ortamlar arasında çalışabilmelidir.

- Güvenlik ve gizlilik standartları: Değerlendirme sürecinde hassas verilerin korunması ve gizlilik düzenlemelerine uyum sağlanması gereklidir.

- Parçalanma ve katı çerçeveler: Mevcut araçların ve kıstasların çoğu belirli metriklere odaklandığından, parçalı bir yaklaşım yaratmaktadır. Ayrıca, katı çerçeveler genellikle yeni veri, kıstas veya bağlamsal unsurlar ekleyecek esnekliği göz ardı ettiğinden gelişen ihtiyaçlara uyum sağlamada sınırlıdır.

Bu zorlukların üstesinden gelmek, güvenilir bilgiler ile AI iş akışlarına sorunsuz entegrasyonu sağlamak için düşünceli bir strateji ve araç kombinasyonunu gerektirir. Aşağıdaki bölümlerde, gerçek dünya uygulamaları için LLM değerlendirmelerini geliştirmek amacıyla bu engelleri aşmak için etkili çözümler keşfedilecektir.

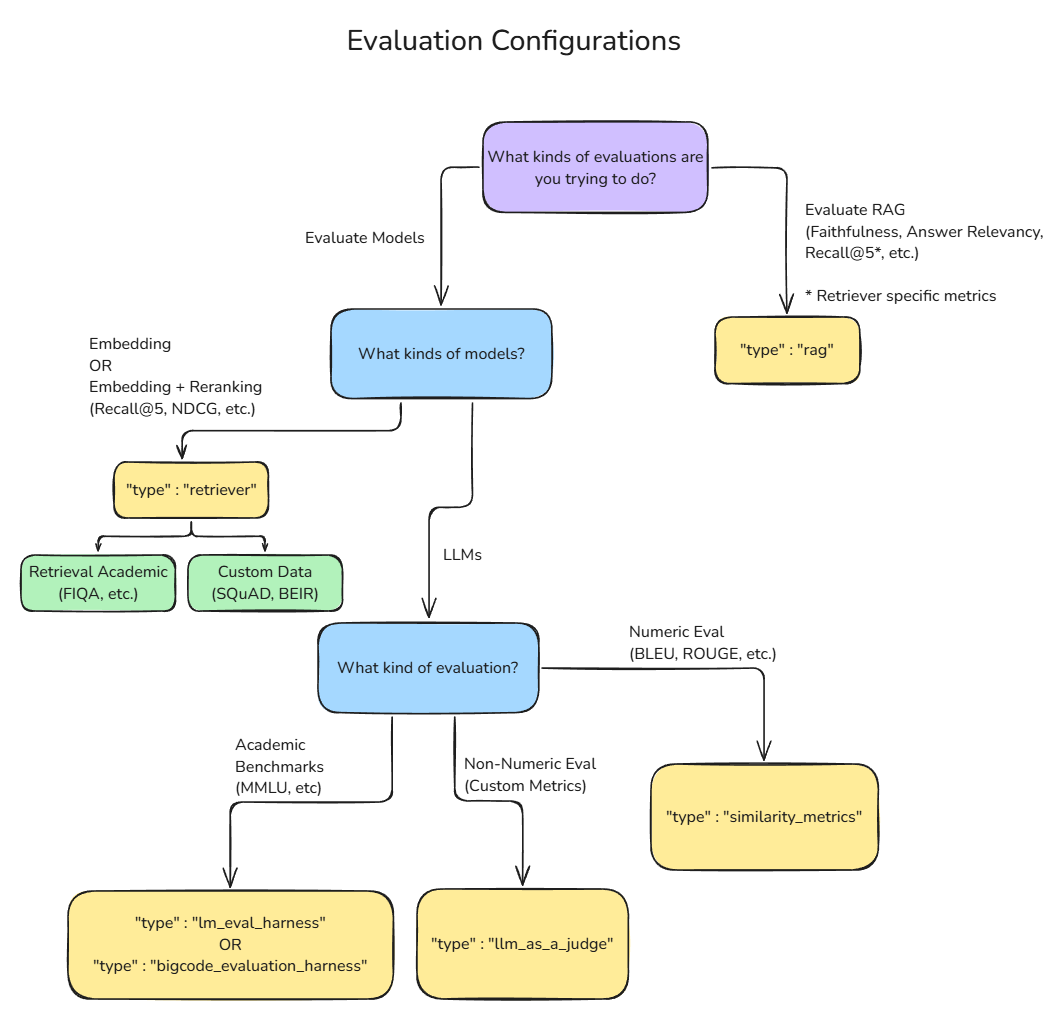

NVIDIA NeMo Evaluator, organizasyonların çok çeşitli hedefler için değerlendirmeyi daha etkin bir şekilde kullanmalarını sağlayan kapsamlı bir çözümdür. NeMo Evaluator, daha önce belirtilen zorlukların çoğunu hafifletirken, iş kritiği taşıyan LLM ve RAG uygulamaları için gerekli olan sağlam ve tutarlı değerlendirmeler elde etmek için basit bir geliştirici deneyimi sunar.

Değerlendirme Stratejileri

LLM’lerin değerlendirilmesi, model performansının belirli yönlerini adreslemek için tasarlanan çok sayıda tamamlayıcı yaklaşım içerir.

NeMo Evaluator Nasıl Değerlendirir

LLM’leri değerlendirme ihtiyacını karşılamak amacıyla, NVIDIA NeMo ekibi, bu yazıda sunulan zorlukların çoğunu çözmeyi hedefleyen bir proje başlattı ve bu proje oldukça kolay bir kurulum ve kullanım olanağı sunuyor. Farklı değerlendirme yapılandırmaları kullanarak geliştiricilerin, son derece özelleştirilebilir değerlendirme boru hatları oluşturmalarını sağlar.

LLM’lerin Değerlendirilmesi

Bir LLM’yi değerlendirmek için aşağıdaki çeşitli yaklaşımlar incelenebilir:

Akademik Kıstaslar

Standartlaştırılmış ölçütler, LLM’leri çeşitli görevler üzerinde değerlendirmek için tutarlı veri setleri ve metrikler sağlar. Aşağıda bazı yaygın kıstaslar verilmiştir. LLM’lerin hızlı bir şekilde geliştiği göz önüne alındığında, akademik kıstaslar hızla doygun hale gelebilir ve LLM’lerin yeteneklerini test etmek için yeni kıstaslar sürekli olarak ortaya çıkacaktır.

Temel Bilgi

- Massive Multitask Language Understanding (MMLU): Bu kıstas, STEM, beşeri bilimler ve sosyal bilimler dahil 57 konuyu kapsayarak LLM’nin bilgi derinliğini ve genişliğini test eder.

- HellaSwag: Günlük senaryolarla ilgili çoktan seçmeli sorular sormak suretiyle LLM’lerin sağduyu akıl yürütme yeteneklerini sınar.

- WinoGrande: Winograd Şeması Yarışması’nın genişletilmiş bir versiyonu olarak, LLM’nin sağduyu akıl yürütme yeteneklerini 44,000 soruluk bir veri seti ile değerlendirir.

Kodlama

- HumanEval: Bu kıstas, bir LLM’nin belirli giriş-çıkış gereksinimleri ile işlevsel kod oluşturarak programlama problemlerini çözme becerisini değerlendirir.

- CodeXGLUE: Farklı programlama görevlerini ve dilleri kapsayan kapsamlı bir kod zekası kıstasıdır.

Soru & Cevap

- ARC Challenge (AI2 Reasoning Challenge): İlkokul düzeyindeki bilim sorularından oluşan ARC Challenge, bir LLM’nin akıl yürütme ve bilimsel bilgiyi uygulama yeteneğini test eder.

- TruthfulQA: 38 konu üzerinden doğru yanıtlar verme becerisini değerlendiren bir testtir.

- TriviaQA: Farklı alanlarda bilgi sorularını yanıtlama yeteneğini değerlendirir.

Sentetik Veri Üretimi

- RewardBench: Dil modellemesi için kullanılan ödül modellerinin yeteneklerini ve güvenliğini değerlendirir, özellikle Direkt Tercih Optimizasyonu (DPO) ile eğitilenleri hedef alır.

- CQ-Syn (Compound Question Synthesis): Karmaşık, çok parçalı soruları işleyebilme kapasitesini değerlendirmek için bileşik sorular üretir.

Talimat Takibi

- IFEVAL: 500 ipucu içeren bir veri seti ile modelin talimat takibi yeteneğini ölçer; bu ipuçları “300 kelimeden fazla yaz” gibi heuristiclerle doğrulanabilir.

- MT-Bench-101: Çok turlu talimatları uygulama yeteneğini değerlendirir.

- BIG-Bench Hard: LLM’nin karmaşık talimatları takip etme yeteneğini test etmek için tasarlanmış zorlu akıl yürütme görevleri içerir.

Çok Dilli

- MGSM: Çok dilli ortamda LLM’nin akıl yürütme yeteneklerini değerlendirir; özellikle karmaşık akıl yürütme görevlerinde.

- XNLI (Çapraz Dilli Doğal Dil Çıkarımı): Bir LLM’nin çoklu dillerde doğal dil çıkarımı yapabilme yeteneğini değerlendirir.

Uzun Bağlam

- LongGenBench: Uzun formlu metinler üretme yeteneğini değerlendirir; karmaşık talimatlar altında uzun diziler boyunca.

- ZeroSCROLLS: Uzun metinler üzerinde doğal dil anlayışı için sıfırdan bir kıstas oluşturur.

Alan Özel

- FinanceBench: LLM performansını finansal sorular üzerinde değerlendirir; SEC belgeleri, kazanç raporları ve finansal analizleri kapsar.

- GSM8K (İlkokul Matematik 8K): İlkokul düzeyindeki matematik problemlerini test ederek LLM’nin matematiksel akıl yürütme becerilerini değerlendirir.

- Massive Multidiscipline Multimodal Understanding and Reasoning (MMMU): Altı temel disiplin boyunca üniversite düzeyindeki bilgiyi kapsar; LLM’lerin uzman düzeyindeki görevleri yerine getirmesini test eder.

Bu çeşitli kıstasları kullanarak, araştırmacılar ve geliştiriciler bir LLM’nin yetenekleri hakkında kapsamlı bir anlayış elde edebilir. Bu çok yönlü değerlendirme yaklaşımı, LLM performansının daha sağlam bir şekilde değerlendirilmesini sağlar ve geliştirilmesi gereken alanları belirler.

Sayısal Değerlendirmeler (Benzerlik Metrikleri)

Geleneksel doğal dil işleme (NLP) benzerlik metrikleri, LLM çıktılarının değerlendirilmesi için niceliksel yöntemler sunar. Yaygın metrikler şunlardır:

- Bilingual Evaluation Understudy(BLEU): Makine çeviri kalitesini, model çıktılarını referans çeviriler ile karşılaştırarak değerlendirir. BLEU skoru 0 (eşleşme yok, yani düşük kalite) ile 1 (tam eşleşme, yani yüksek kalite) arasında değişir.

- Recall-Oriented Understudy for Gisting Evaluation (ROUGE): Makine tarafından üretilen özetler ile insan tarafından üretilen özetler arasındaki örtüşmeyi ölçer. ROUGE skoru 0 ile 1 arasında değişir; daha yüksek skorlar daha yüksek benzerlik olduğunu gösterir.

- Perplexity: Kelime dizilerinin tahminindeki belirsizliği ölçerek daha düşük değerlerin daha iyi tahmin performansını gösterdiğini belirtir.

Embedding veya Reranking Modellerinin Değerlendirilmesi

Embedding ve reranking modelleri sıklıkla geri alma tabanlı görevlerde kullanılır. Bu modellerin değerlendirilmesi, LLM tabanlı uygulamaların sağlamlığını sağlamak açısından kritik öneme sahiptir.

Bu modellerin değerlendirilmesinde birçok standart metrik kullanılmaktadır:

- Precision@K: Bir grup K geri alınmış belgede ne oranda ilgili belgelerin bulunduğunu ölçer.

- Recall@K: K geri alınmış belgede başarılı bir şekilde geri alınan ilgili belgelerin oranını değerlendirir.

- Alaka Düzeyi: Geri alınan bilgilerin sorgu veya bağlam ile ne kadar uyumlu olduğunu değerlendirir.

- Zamansal Unsurlar: Geri alınan bilgilerin güncelliği ve zamanlamasını dikkate alır.

Reranking, geri alma sürecine destek verir ve bunu bir tür kontrol mekanizması olarak düşünebilirsiniz. Embedding veya embedding artı reranking boru hatlarında kullanılan metrikler aynıdır.

RAG Sistemlerinin Değerlendirilmesi

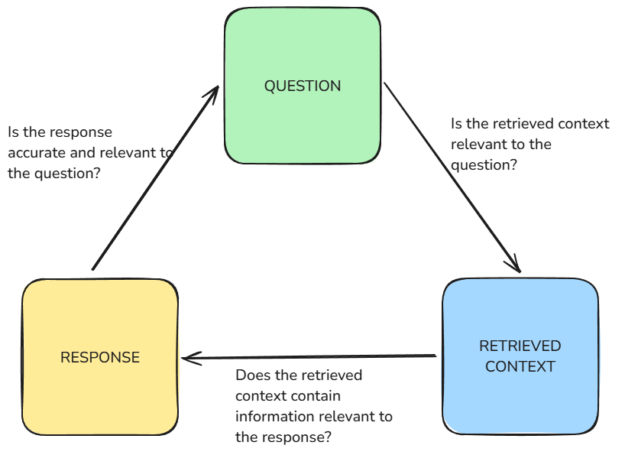

RAG sistemlerinin değerlendirilmesi, genel LLM değerlendirmesinden farklı özellikler sunan özel zorluklar içerir. Bu karmaşıklık, RAG sistemlerinin hem bilgi geri alma hem de metin üretimini bir araya getirmesinden kaynaklanmaktadır.

RAG sistemlerinin değerlendirilmesinde geleneksel metrikler yetersiz kalır çünkü bunlar esas olarak metin benzerliğine odaklanır ve RAG sistemlerinin performansını ölçme konusunda yeterince etkili olamazlar. Bunun nedeni, bu metriklerin gerçeklik doğruluğu ve bağlamsal uygunluk gibi karmaşık ölçütleri yeterince ölçememesidir.

RAG sistemlerinin değerlendirilmesi, hem geri alma hem de üretim bileşenini kapsamlı bir şekilde değerlendirmeyi gerektirir. Bu değerlendirme, bu iki bileşeni bağımsız olarak ve entegre bir bütün olarak incelemelidir.

RAG sistemlerinin geri alma bileşeni daha önce açıklandığı gibi değerlendirilmeli; bu durum, NeMo Evaluator kullanmanın bir avantajıdır çünkü kullanıcıların modüler değerlendirme boru hatları oluşturmalarını sağlar.

Üretim bileşeni, geri alınan bilgilere dayanarak mantıklı, bağlama uygun ve gerçekten doğru metinler üretme yeteneği açısından değerlendirilmelidir. Bu değerlendirme aşağıdaki unsurları dikkate almalıdır:

- Tutarlılık: Üretilen metnin ne kadar akıcı olduğu ve mantıksal tutarlılığı ne oranda koruduğu.

- Bağlamsal Uygunluk: Üretilen içeriğin verilen sorgu veya bağlam için uygun olup olmadığı.

- Gerçeklik Doğruluğu: Üretilen metindeki herhangi bir bilginin doğruluğu.

RAG sistemlerini kapsamlı bir şekilde değerlendirmek için aşağıdaki uçtan uca akış kullanılabilir:

- Sentetik Veri Üretimi (SDG): Vektör deposundaki belgeleri temel alarak, soru-cevap-bağlam setleri oluşturmak için NVIDIA Nemotron gibi bir model kullanabilirsiniz.

- Sorgu İşleme: Sistem, giriş sorgusunu ne kadar iyi yorumlayıp işlediğini analiz edin.

- Bilgi Geri Alma: Kullanılan metrikler (örneğin, doğruluk ve geri çağırma) ile geri alınan bilgilerin alaka düzeyini ve kalitesini değerlendirin.

- İçerik Üretimi: Üretilen metnin kalitesini, tutarlılığını ve gerçeklik doğruluğunu değerlendirin.

- Genel Çıktı Değerlendirmesi: Nihai çıktının, orijinal sorguya olan alakasını, gerçeklik doğruluğunu ve yararlılığını değerlendirin.

- Karşılaştırmalı Analiz: RAG sisteminin performansını temel modeller veya insan tarafından üretilen yanıtlar ile karşılaştırın.

Geleneksel metriklerin yetersizliklerini gidermek için RAG değerlendirmesi için birkaç özel metrik önerilmiştir ve bu metrikler, NeMo Evaluator’da Ragas çerçevesi aracılığıyla sağlanmaktadır:

- Geri Alma Doğruluğu: Geri alınan belgelerin ne kadarının sorguya uygun olduğunu ölçer.

- Geri Alma Hatırlaması: Toplamda ilgili belgelerden ne kadarının geri alındığını değerlendirir.

- Sadakat: Üretilen cevabın verilen bağlamla ne kadar tutarlı olduğunu ölçer.

- Cevap Alaka Düzeyi: Üretilen cevabın verilen sorguya ne kadar uygun olduğunu değerlendirir.

Üretken AI Doğruluğunu Değerlendirmede Gelecek Adımlar

Bu yazı, değerlendirmedeki zorluklar ve başarılı bulunan bazı yaklaşımlara genel bir bakış sağlamaktadır. Değerlendirme, düşünülmesi karmaşık bir konudur, birçok özelleştirme ve istediğiniz aşağı akış görevlerine uyum sağlama alanı içerir. Ayrıca, bazı teknik ve uygulama engelleri kritik geliştirme süresini tüketebilir.

NeMo Evaluator ile, önerilen çözümler sayesinde daha faydalı yinelemelere ve iyileştirme döngülerine daha fazla zaman ayırabilirsiniz. NeMo Evaluator şu anda Erken Erişim aşamasındadır. Eğer değerlendirme iş akışınızı hızlandırmak istiyorsanız, NeMo Evaluator için Erken Erişim başvurusunda bulunun.