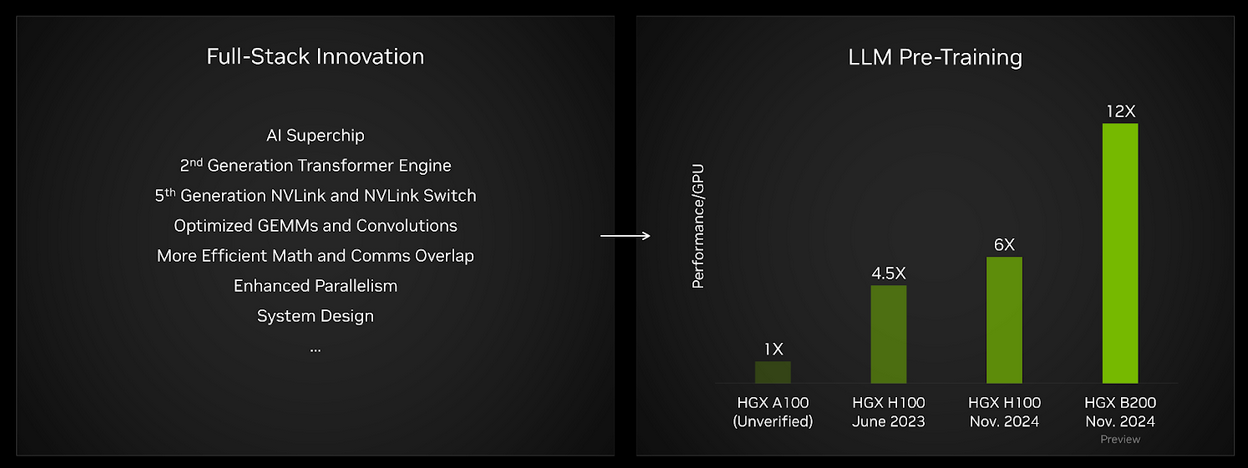

Modeller büyüdükçe ve daha fazla veriyle eğitildikçe, yetenekleri artmakta ve bu da onları daha kullanışlı hale getirmektedir. Bu modelleri daha hızlı bir şekilde eğitmek için, veri merkezi ölçeğinde daha fazla performansa ihtiyaç vardır. NVIDIA’nın 2024 GTC etkinliğinde tanıttığı Blackwell platformu, yedi farklı çip türünü entegre eden bir yapıdır: GPU, CPU, DPU, NVLink Switch çipi, InfiniBand Switch ve Ethernet Switch. Blackwell platformu, GPU başına performansta büyük bir sıçrama sağlamaktadır ve yeni nesil büyük ölçekli AI kümelerinin oluşturulmasına olanak tanıyarak, bir sonraki nesil büyük dil modellerinin gelişimini desteklemektedir.

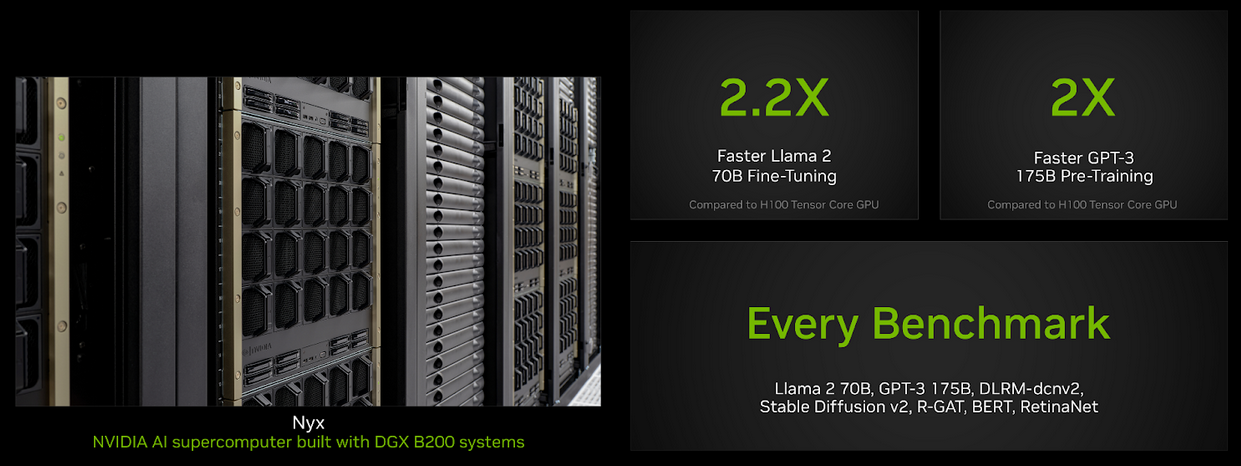

Son MLPerf Training raporunda—yapay zeka eğitiminde kullanılan bir benchmark seti—NVIDIA, Blackwell platformunu ilk kez ön izleme kategorisinde sunmuştur. Bu sonuçlar, Hopper tabanlı sonuçlarla karşılaştırıldığında, her MLPerf Training benchmark’ında büyük kazançlar göstermektedir. Özellikle, GPT-3 ön eğitiminde GPU başına performans %200 artarken, Llama 2 70B düşük sıralı adaptasyonu (LoRA) ince ayarında ise %220’lik bir artış sağlanmıştır. NVIDIA, bu raundda Blackwell ile her MLPerf Training benchmark’ında sonuçlarını sunarak Hopper ile karşılaştırıldığında sağlam kazançlar elde etmiştir.

Blackwell Platformunda Yenilikler

Her yeni platform nesli ile birlikte, NVIDIA, geliştiricilerin yüksek iş yükü performansı elde etmesine yardımcı olmak için donanım ve yazılımı kapsamlı bir şekilde birlikte tasarlamaktadır. Blackwell GPU mimarisi, Tensor Core hesaplama throughput ve bellek bant genişliğinde büyük sıçramalar sağlar. Bu raundda Blackwell’in önemli yeniliklerinden bazıları şunlardır:

- Optimize Edilmiş GEMM’ler, Konvolüsyonlar ve Çoklu Başlı Dikkat: Blackwell GPU mimarisindeki daha hızlı ve verimli Tensor Core’lara etkili bir şekilde kullanılan yeni çekirdekler geliştirilmiştir.

- Daha Verimli Hesaplama ve İletişim Üst Üste Binen Kullanım: Mimari ve yazılım geliştirmeleri, çoklu GPU uygulamalarında mevcut GPU kaynaklarının daha iyi kullanılmasını sağlar.

- Geliştirilmiş Bellek Bant Genişliği Kullanımı: İlk olarak Hopper mimarisinde tanıtılan Tensor Memory Accelerator (TMA) yeteneğini kullanan yeni yazılım, birçok işlemin, normalizasyonlar da dahil olmak üzere, HBM bant genişliğini daha etkili bir şekilde kullanmasına yardımcı olmaktadır.

- Daha Performant Paralel Haritalama: Blackwell GPU’ları, daha büyük HBM kapasitesi sunarak, dil modellerinin donanım kaynaklarını daha verimli bir şekilde kullanmasını sağlar.

Ayrıca, Hopper üzerindeki performansı artırmak için cuBLAS‘a daha esnek döşeme seçenekleri ve geliştirilmiş veri yerelliği desteği eklenmiştir. Gelişmiş cuDNN çoklu başlı dikkat ve konvolüsyon çekirdekleri, cuDNN Runtime Fusion Motorları ile optimize edilmiştir. NVIDIA’nın Transformer Engine kütüphanesi, yukarıda açıklanan optimizasyonlar aracılığıyla dil modelleri için optimize edilmiş performansı sağlamada önemli bir rol oynamıştır.

Blackwell ile LLM Ön Eğitimi

MLPerf Training setinde bulunan LLM ön eğitimi benchmark’ı, OpenAI tarafından geliştirilen GPT-3 modeline dayanmaktadır. Bu test, en son teknoloji ile oluşturulan temel model eğitimi performansını temsil etmekte olup, Blackwell sonuçları bu raundda GPU başına performans açısından Hopper’ın dördüncü gönderiminde iki kat artış sağlamıştır. HGX A100 ile elde edilen sonuçlarla karşılaştırıldığında, GPU başına yaklaşık 12 kat artış sağlanmıştır.

Ayrıca, Blackwell GPU’larının daha büyük ve daha yüksek bant genişliğine sahip HBM3e bellek yapısı sayesinde, GPT-3 benchmark’ı yalnızca 64 GPU kullanılarak çalıştırılabilmiştir. Oysa, HGX H100 kullanarak optimal performansı elde etmek için 256 GPU’luk (32 HGX H100 sunucusu) bir gönderim ölçeğine ihtiyaç vardı. Daha yüksek GPU başına hesaplama throughput’u ve daha büyük, daha hızlı yüksek bant genişliğine sahip bellek kombinasyonu, GPT-3 175B benchmark’ının daha az GPU ile mükemmel performansla çalıştırılabilmesine olanak tanımaktadır.

Blackwell ile LLM İnce Ayar Hızlandırma

Büyük ve yetenekli topluluk LLM’lerinin, örneğin Meta’nın Llama aile modellerinin ortaya çıkmasıyla, işletmeler spesifik görevlerde performansı artırmak için bu modelleri özelleştirebilirler. MLPerf Training yeni bir LLM ince ayar benchmark’ı eklemiştir ve bu sürekli ince ayar gerçekleştirilmesini sağlayan düşük sıralı adaptasyonu (LoRA) kullanmaktadır.

LLM ince ayar benchmark’ında, tek bir HGX B200 sunucusu, HGX H100 sunucusuna kıyasla %220 daha fazla performans sunmaktadır. Bu, organizasyonların Blackwell sayesinde LLM’leri daha hızlı özelleştirmelerine, böylece dağıtım süresini ve nihayetinde değerini hızlandırmalarına olanak tanımaktadır.

Blackwell’ın Her Benchmark’daki Başarıları

NVIDIA, Blackwell kullanarak her benchmarkta sonuçlar sunmuş ve önemli performans artışları elde etmiştir.

| Benchmark | Blackwell GPU Başına Artış |

| LLM LoRA İnce Ayarı | 2,2x |

| LLM Ön Eğitimi | 2,0x |

| Grafik Sinir Ağı | 2,0x |

| Metinden Görüntüye | 1,7x |

| Tavsiyeler | 1,6x |

| Nesne Tanıma | 1,6x |

| Doğal Dil İşleme | 1,4x |

Hopper İyi Performansını Sürdürüyor

NVIDIA’nın Hopper mimarisi, MLPerf Training v4.1‘de hem mevcut çözümler arasında en yüksek performansı sunmaya devam etmiştir. Örneğin, GPT-3 175B benchmark’ında Hopper’ın per-akselerör temelinde performansı, 2023 Haziran’ında yayınlanan MLPerf Training v3.0‘dan itibaren %30 artış göstermiştir.

GPU başına daha iyi performans sağlamakla birlikte, NVIDIA, ölçek verimliliğini de büyük ölçüde artırarak, 11,616 H100 GPU kullanarak bir GPT-3 175B gönderiminde benchmark kayıtlarını korumaya devam etmektedir.

NVIDIA ayrıca, HGX H200 platformunu kullanarak sonuçlar sunmuştur. NVIDIA’nın H200 Tensor Core GPU’su, NVIDIA H100 Tensor Core GPU ile aynı kayıt mimarisine dayanmakta, HBM3e bellek ile donatılmaktadır. Bu yapı, 1.8 kat daha fazla bellek kapasitesi ve 1.4 kat daha fazla bellek bant genişliği sunmaktadır. Llama 2 70B düşük sıralı adaptasyon (LoRA) benchmark’ında, H200 ile yapılan 8 GPU’luk gönderim, H100’e göre %16 daha iyi performans sağlamıştır.

Önemli Noktalar

NVIDIA Blackwell platformu, MLPerf Training sonuçlarında gösterildiği üzere, özellikle LLM ön eğitimi ve ince ayarında Hopper platformuna kıyasla önemli bir performans sıçraması sunmaktadır. Ayrıca, Hopper da GPU başına ve ölçek bazında yüksek performans sunmaya devam etmekte ve yazılım optimizasyonları, sunumundan bu yana performansı artırmıştır. Gelecek MLPerf Training turlarında, Blackwell’i daha büyük ölçeklerde sunmayı dört gözle bekliyoruz ve yeni GB200 NVL72 sistemi ile sonuçlar sunmayı da planlıyoruz.